Важность индексации

Алгоритм ранжирования в поисковиках — сложная технология, которая спрятана в цифровом Форт-Ноксе. Все знают, что она существует, но точно неизвестно, как работает виртуальный механизм.

Есть неочевидные вещи, о которых забывают многие веб-мастера в попытках повлиять на ранжирование. Чтобы на сайте появился трафик, страницы с полезным контентом должны присутствовать в базе поисковых систем. Большинство сайтов без проблем индексируются и привлекают быстроботов. Круто, если статьи доступны аудитории Google и Яндекса через считанные минуты после публикации. Переходы и хорошие поведенческие факторы повлияют на ранжирование, и статья может закрепиться на верхних строчках выдачи, даже когда волшебство быстрого робота закончится.

Как проверить индексацию в поисковых системах

Страницы попадают в индекс после того, как маленькие помощники поисковых систем заходят в «гости» и нет причин не добавлять страницу в базу.

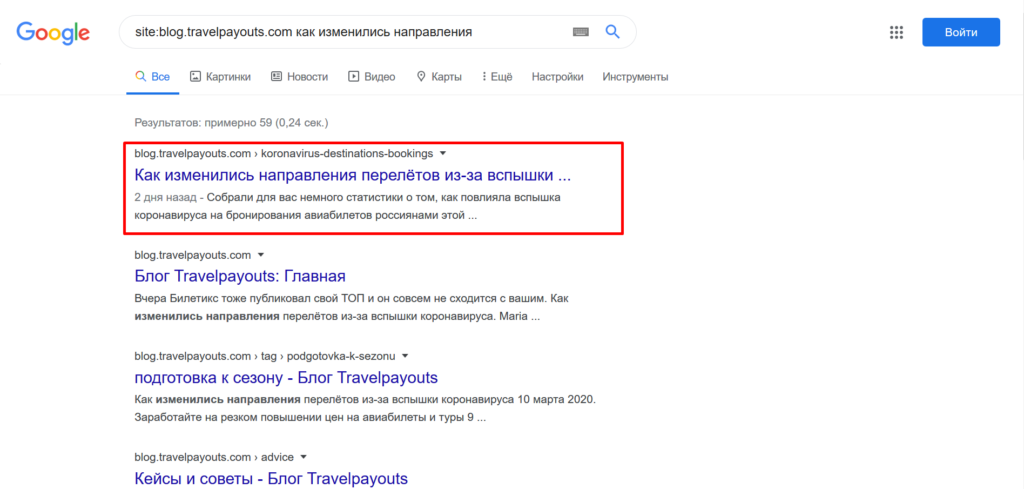

Есть 4 простых способа проверить индексацию:

- Вставить URL в поисковую строку.

- Использовать оператор site:domain.ru и название статьи.

- Запустить поиск по куску текста.

- Использовать оператор url:адрес статьи.

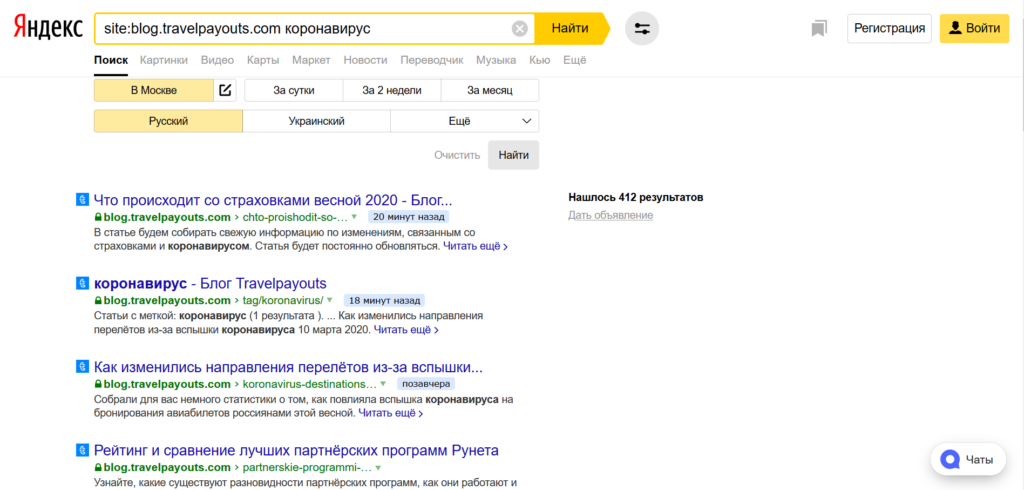

В поисковых системах есть блок настроек, которым мало кто пользуется. С помощью фильтров можно узнать, сколько статей попали в индекс за месяц. Относитесь к этим данным критично. Страницы часто вылетают из поиска и через время возвращаются снова. Поэтому надо смотреть не только дату попадания в базу Яндекса и Google, но и дату публикации.

Инструменты для проверки индексации

Выдача поисковых систем не всегда даёт правильную информацию. Лучше воспользоваться удобными решениями, которые точно покажут, когда роботы заходили на страницу в последний раз и почему не добавили её в индекс.

Search Console и Yandex Webmaster

Консоли для веб-мастеров есть у Яндекса и Google. Они отличаются дизайном, структурой и возможностями, но задача у двух инструментов одинаковая — дать владельцу сайта возможность управлять важными параметрами.

В «Яндекс Вебмастер» под индексирование выделено отдельное меню. В нём доступна статистика обхода, список страниц в поиске, структура категорий, мониторинг важных страниц и файлы sitemap.

Для быстрой проверки индексации найдите инструмент «Проверить статус URL», вставьте адрес и нажмите жёлтую кнопку.

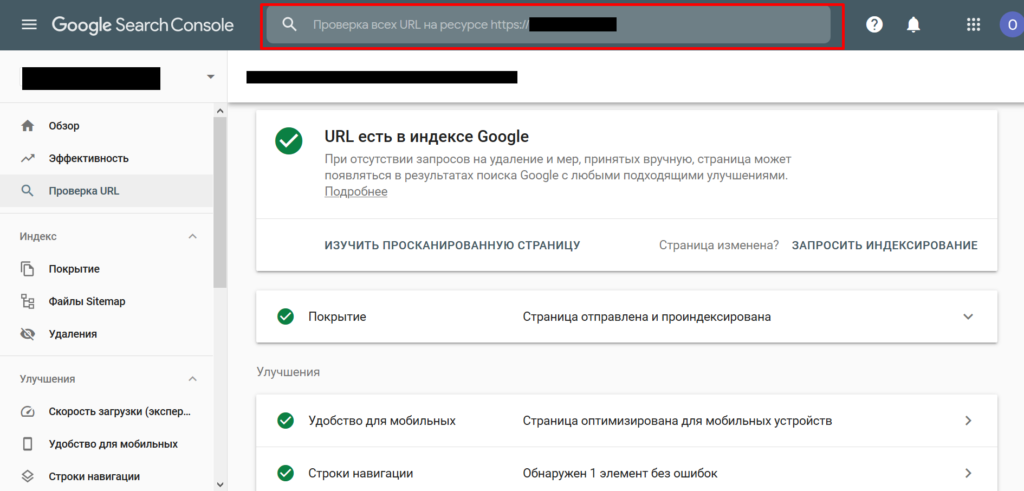

В Google возможностей меньше. Для проверки адреса вставьте его в верхнюю строку и дождитесь обработки данных.

В табах отображается дополнительная информация, которая помогает выявить проблемы с индексацией

- последнее сканирование;

- разрешение на индексацию;

- каноническая страница.

Если инструменты для веб-мастеров не устраивают, можно воспользоваться специальными решениями, которые проверяют наличие статей в базе Яндекса и Google. Вариантов много: сервисы, расширения для браузеров, десктопные программы.

Arsenkin Tools

Популярный сервис, которым активно пользуются SEO-специалисты. На бесплатном тарифе можно проверить 200 страниц на индексацию в Яндексе. Доступ к Google открывается только после оплаты подписки.

- Плюсы: выгрузка отчётов в формат Excel, 200 лимитов в день.

- Минусы: длительная обработка данных.

- Стоимость: зависит от тарифа.

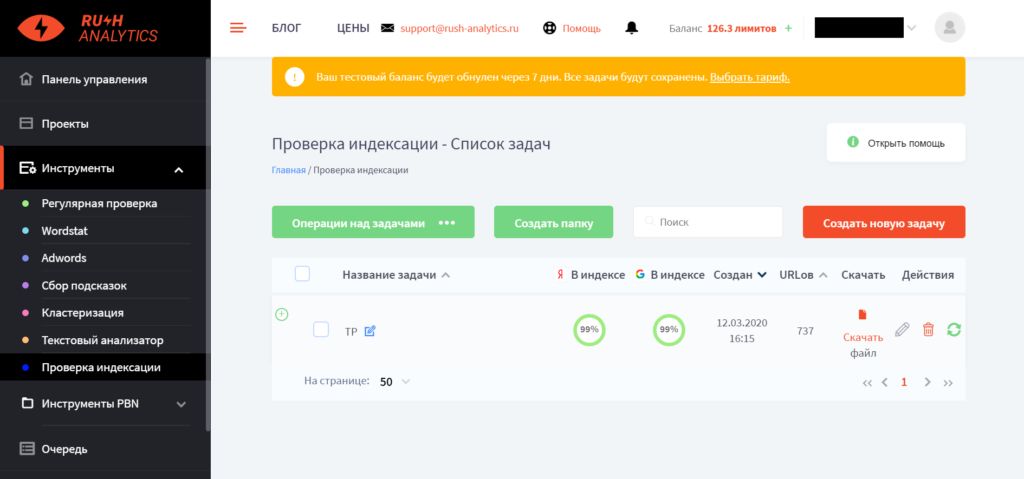

Rush-Analytics

Сервис работает по принципу облака. Создаёте задачу, настраиваете параметры и ждёте окончания сбора данных.

- Плюсы: выбор региона и языка в Google, 200 бесплатных лимитов, импорт адресов из sitemap, проверка индексации в real-time, автоматическое удаление дубликатов.

- Минусы: после использования тестовых лимитов надо платить.

- Стоимость: зависит от тарифа.

Как массово проверить индексацию

Для небольших сайтов с периодическим обновлением контента вполне хватит ручной проверки индексации. Если страниц много, новые материалы появляются каждый день, проверяйте данные ежедневно.

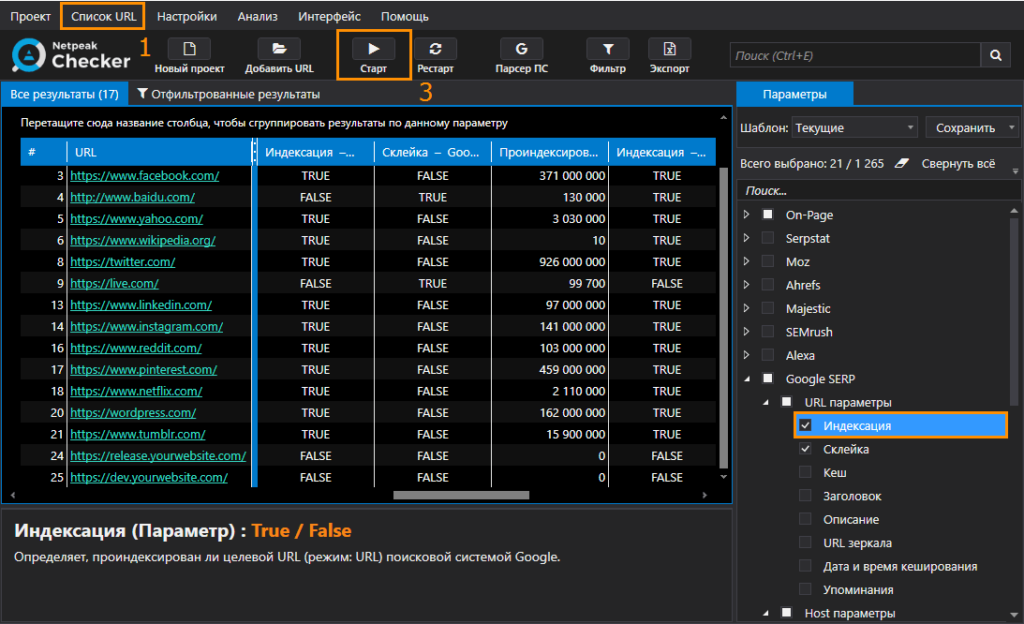

Netpeak Checker

Десктопная программа с 14-дневным триалом от известного digital агентства Netpeak — комбайн для SEO-задач.

Проверка индексации — одна из сотни встроенных опций. Добавляете список URL-адресов, запускаете проверку и ждёте результат. Если страница есть в базе напротив адреса появится значение «true».

- Плюсы: хранение данных в проекте, поддержка 4 поисковых систем.

- Минусы: высокая стоимость, нужны XML-лимиты, прокси и антикапча.

- Стоимость: лицензия на год стоит 182 доллара. Покупать её стоит только если будете использовать другие модули софта. Для проверки индексации лучше пользоваться Rush-Analytics или аналогом.

Что влияет на индексацию

Веб-мастера, которые занимаются созданием и продвижением информационных сайтов, должны знать, как работает механизм индексации, и что влияет на попадание страницы в базу. Новичкам и опытным пригодятся официальные рекомендации Яндекса и Google по этому вопросу.

Страница попадает в индекс после того, как поисковый робот посещает её, загружает копию на сервер и алгоритм определяет, что нет причин для отказа в индексации.

Есть 3 условия, которые влияют на попадание страницы в базу поисковиков:

- она должна быть доступна для индексации;

- робот должен её посетить;

- робот должен посчитать страницу важной.

Если краулер зашёл на сайт, и страница не появилась в индексе, надо проверить её на проблемы, устранить их и отправить URL-адреса на переобход. Если ошибка не связана с глобальными неполадками поисковых систем, значит дело в сайте.

Поисковики прямо говорят, что не все страницы попадут в выдачу и будут ранжироваться по тематическим запросам. Резервы дата-центров Яндекса и Google огромные, но у них есть ограничения. Недавно Яндекс сильно сократил количество адресов в результатах поиска — с 1000 до 250. Раньше страниц было 100, а теперь только 25. Пресс-служба поисковой системы сказала, что после серии исследований специалисты приняли решение не показывать результаты дальше 25 страницы. 250 сайтов хватит для решения задач пользователей.

В нишах с высокой конкуренцией придётся бороться не только за ТОП-10, но и за попадание статьи в 250 доступных адресов. Индексация — важный компонент для успешного развития сайта и наращивания поискового трафика.

Формула успеха: полезный контент + соблюдение рекомендаций поисковых систем = profit.

Факторы, ускоряющие индексацию

- Внутренние и внешние ссылки. Поисковые системы часто посещают главные страницы сайтов и особо ценят URL с высокой посещаемостью. Если на новую статью не будет ссылок с главной или sitemap, роботы её не найдут.

- Перелинковка. Многие веб-мастера в новых статьях ссылаются на старые. Не забывайте линковать старые статьи с новыми.

- Социальные сети. Упоминания в социальных сетях всегда считались важными. 3-4 года назад с помощью Твиттера можно было «загнать» в индекс практически любую страницу.

- Обновление контента. Если на сайте каждый день появляется 3-4 полезных статьи, есть шанс привлечь быстророботов.

Популярный миф о том, что настройка AMP и Turbo ускоряет индексацию, разрушен ещё в 2018 году. Google сканирует и добавляет в базу AMP-страницы с такой же скорость, как и обычные. Более того, внедрение технологий быстрой загрузки не влияет на ранжирование.

Разница в механизме индексации поисковиков

Важно понять, что Google и Яндекс — две разные поисковые системы. У них свои факторы ранжирования и особенности продвижения.

Принцип добавления новых URL в базу поисковиков мало чем отличается, но разница в количестве проиндексированных страниц может отличаться в десятки раз. Это связано с тем, что поисковики по-разному взаимодействуют с контентом сайта и директивами в robots.txt. Google часто игнорирует robots и хорошо воспринимает тег content=”noindex”.

Полнота индекса в поисковых системах может сильно отличаться. Если страница проиндексирована в Яндексе, нет гарантий, что она попадёт и в Google. Владельцам крупных порталов надо познакомиться с понятием краулинговый бюджет. Это количество адресов на сайте, которое может просканировать бот Google. Если страницы однотипные, в выдачу попадёт только часть из них.

Как «загнать» страницу в индекс

2-3 года назад страницы сайтов, у которых не было быстробота, попадали в выдачу Яндекса с каждым новым апдейтом. Иногда данные обновлялись раз в неделю, иногда раз в месяц. Веб-мастера следили за новостями на тематических форумах и обменивались наблюдениями. В то время Яндекс серьёзно отставал от Google в плане индексации. Сейчас ситуация выровнялась, и в некоторых случаях поисковик с российскими корнями добавляет страницы в базу быстрее.

В конце прошлого года у Google были серьёзные проблемы с индексацией. Добавленные адреса пропадали из выдачи, новые появлялись очень медленно. В данный момент на SEO форумах никто не поднимает панику, значит ситуация стабилизировалась.

Консоли веб-мастеров

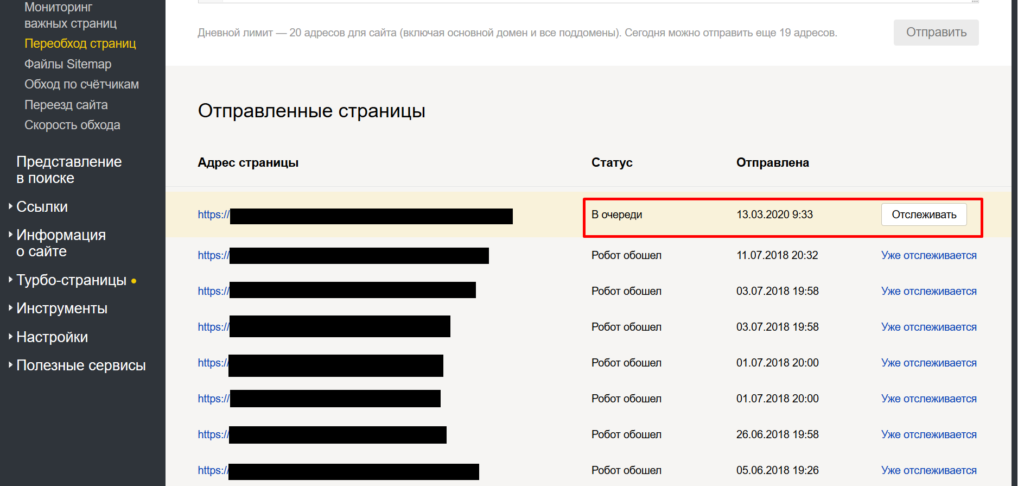

Самый простой способ «загнать» статью в индекс — стандартные инструменты поисковиков для владельцев сайтов.

В «Яндекс Вебмастере» в разделе «Индексирование» найдите пункт «Переобход страниц». Вставьте в поле до 20 адресов, которые робот должен обойти повторно или впервые и нажмите на кнопку «Отправить». Когда YandexBot посетит URL, статус поменяется на «Робот обошёл». После этого страница попадёт сначала в промежуточную базу, а после апдейта — в основную.

Присмотритесь к инструменту «Мониторинг важных страниц». В него можно добавить 20 самых важных страниц. Если есть статьи, которые собирают больше всего трафика долгие годы — соберите их в этом интерфейсе и будете получать уведомления о любых изменениях.

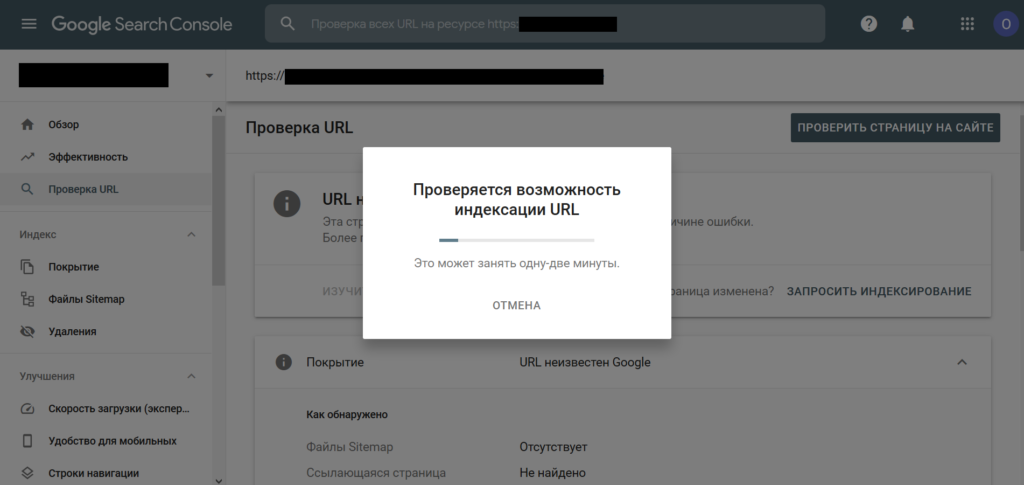

В Google механизм добавления страницы в очередь на индексацию отличается. Откройте Search Console, вставьте адрес в верхнее поле и дождитесь загрузки данных. Если URL не в индексе, нажмите кнопку «Запросить индексирование». От запроса до попадания в базу проходит от нескольких минут до нескольких дней.

В Яндексе маленький дневной лимит на переобход страниц, а в Google каждый адрес надо вставлять вручную. Владельцам крупных порталов с пользовательским контентом не обойтись без специальных инструментов, которые могут ускорить индексирование. Почти все они ориентированы на Google.

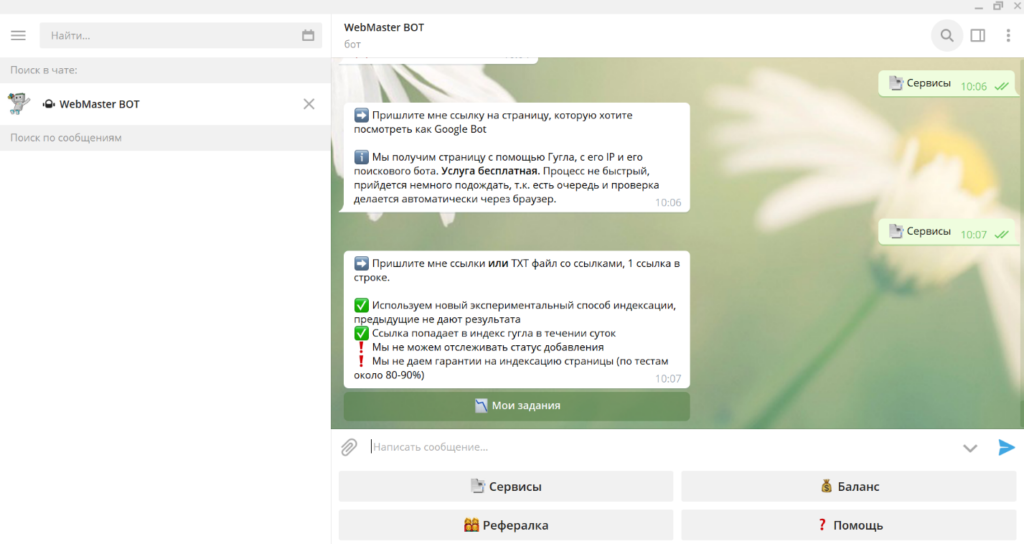

Webmaster bot

Популярный Телеграм-бот для SEO-задач. За копейки выгружает данные из Ahrefs, SEMrush и добавляет страницы в индекс Google.

- Плюсы: индексация в течение суток, нативный интерфейс.

- Минусы: инструменты часто недоступны.

- Стоимость: 1 рубль за URL.

Плагин Indexer

Расширение для Yandex Browser и Chrome. Разработчик узнал, что если посетить любую страницу с браузера Яндекса, то на неё обязательно зайдёт YandexBot и проиндексирует. Автор протестировал плагин для индексации страниц сомнительного качества и Indexer показал себя хорошо. Если будете пробовать, обязательно вставляйте ссылки с протоколом http / https.

- Плюсы: высокая скорость, настройка таймера, нет ограничения по количеству адресов.

- Минусы: только под Яндекс.

- Стоимость: бесплатно.

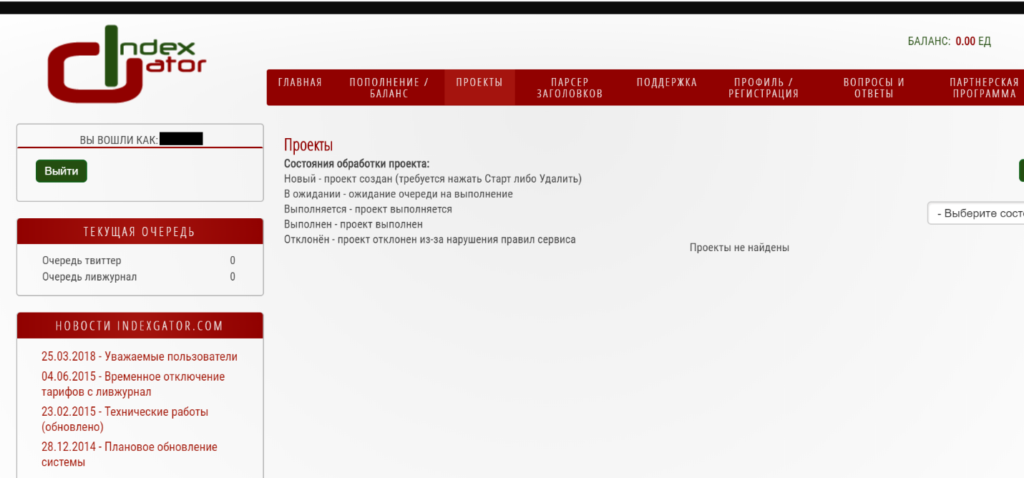

IndexGator

Сервис ускоряет индексацию контента ссылками с Twitter и LiveJournal. В базе 2000 аккаунтов Twitter и столько же профилей «ЖЖ».

- Плюсы: поддержка Яндекса и Google, низкая цена.

- Минусы: медленная техподдержка, нет бесплатных лимитов.

- Стоимость: от 0,3 до 1 рубля за URL.

В сети есть упоминания о сервисе IndexMe. Не рекомендуем им пользоваться, автор скрипта получал все отправленные адреса. После того, как веб-мастера обнаружили слив данных, разработчик устранил проблему. Безопасность инструмента под большим сомнением.

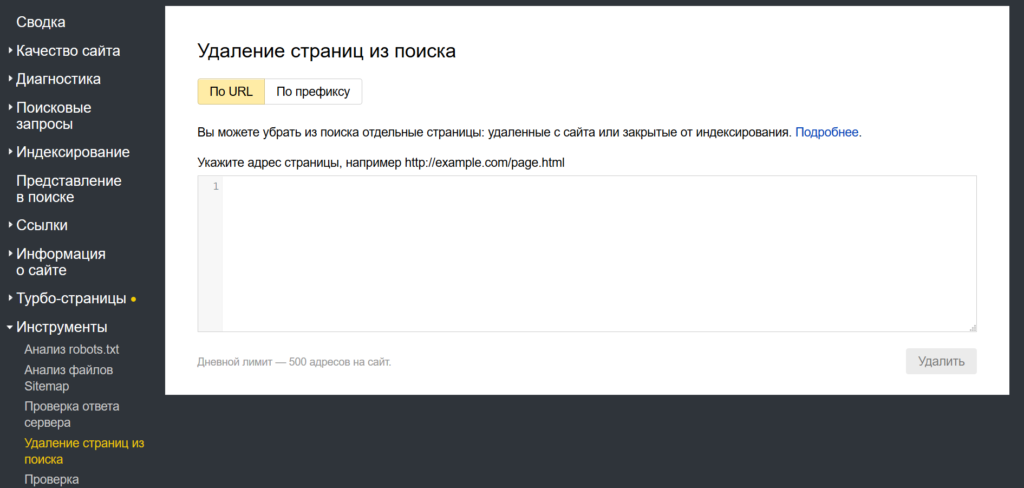

Как страницу удалить из индекса

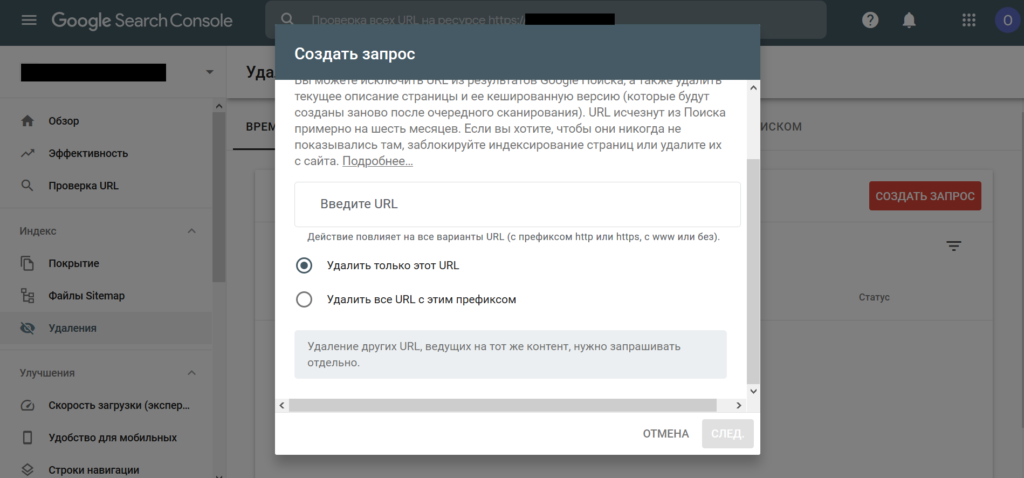

Поисковые системы часто добавляют в базу адреса, которые заблокированы в robots.txt. От них лучше избавиться, чтобы оставить только страницы с полезным контентом. Есть несколько способов удаления URL-адресов из индекса: закрыть от краулеров, сделать редирект или воспользоваться инструментами в консолях для веб-мастеров.

В Яндексе страницы можно удалить из меню «Инструменты». Дневной лимит 500 адресов, реализована поддержка массового импорта. Google в этом плане сильно уступает по удобству. Складывается ощущение, что поисковая система специально усложняет жизнь веб-мастерам.

Google недавно обновил структуру Search Console. Список запросов на временное удаление контента доступен в одноименной вкладке. Для исключения страницы откройте меню и добавьте URL. С помощью префикса можно удалить все страницы категории или каталог товаров. Перед использованием модуля прочитайте справку. Если хотите избавиться от страницы навсегда воспользуйтесь рекомендациями Google.

Чек-лист: почему может не индексироваться страница

У информационных сайтов и блогов до 1000 страниц обычно нет проблем с индексацией. Трудности часто возникают у больших порталов с десятками тысяч URL-адресов. Особенно, если контент однотипный и отличается только геопривязкой.

Что надо проверить:

- Доступность sitemap.xml.

- Наличие страницы в карте сайта.

- Посещение краулерами.

- Уникальность контента.

- Скорость загрузки.

- Наличие дублей.

- Вложенность страницы.

- Внутренние ссылки.

- Тег robots.

- Ответ сервера.

- Главное зеркало.

Если у сайта много трафика и хороший профит, создайте проект в Топвизоре. Сервис каждый день проверяет индексацию страниц и присылает отчёты на почту или в Телеграм. Так вы будете в курсе событий и сможете разобраться с критическими ошибками.

Импортировать список страниц можно из файла на компьютере или sitemap. Стоимость проверки зависит от тарифа, на минимальном 0,1 доллар за 100 страниц в одном поисковике. За 1081 URL из карты нашего блога сервис просит 4,32 доллара.

Обязательно следите за индексацией нового контента и регулярно проверяйте наличие страниц в индексе. В идеале, количество URL-адресов в sitemap и выдаче должно совпадать.