Далее мы публикуем текст от лица автора.

Днями я случайно обнаружила, что мы вступили в новую реальность. Такие мысли закрались в мою голову во время изучения статистики посещаемости в Яндекс.Метрике. Я заметила всплески трафика из социальных сетей и прямых заходов на страницы, которые в данный момент практически не актуальны. У меня инфосайт по туризму, но сейчас свирепствует коронавирус, границы закрыты, туристические визы не выдают, СМИ стращают так, что народ опасается ездить даже по России.

Я подключила Вебвизор и посмотрела, что это за визиты (Вебвизор обычно выключен, скорость загрузки без него увеличивается). И я узнала много нового.

Как выявить ботов

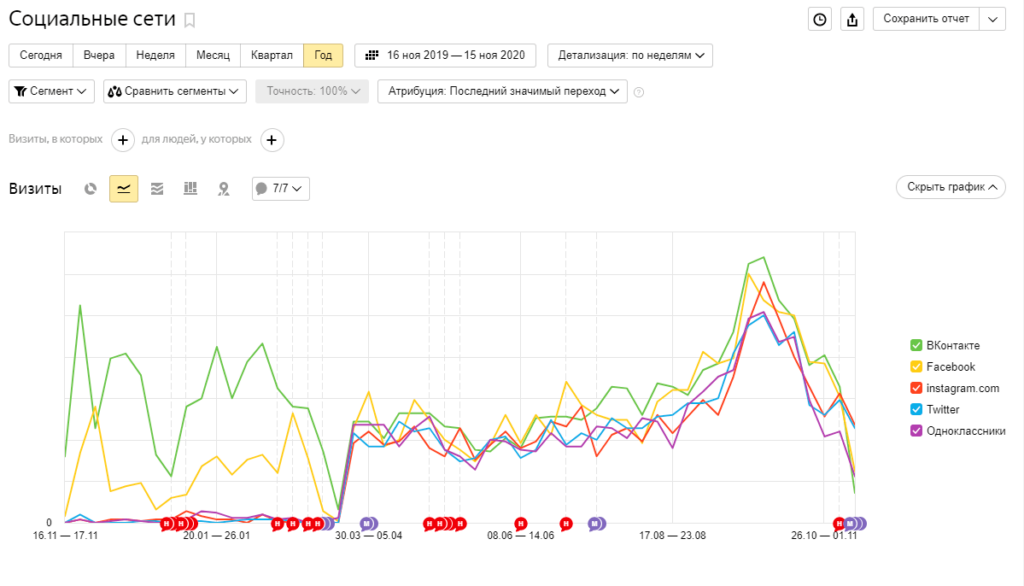

Оказывается, мой сайт уже давно, с конца марта, посещают просто толпы ботов при помощи переходов из социальных сетей. Вы явно замечаете изменение характера графика, но я ничего не делала, политику продвижения в социальных сетях не меняла.

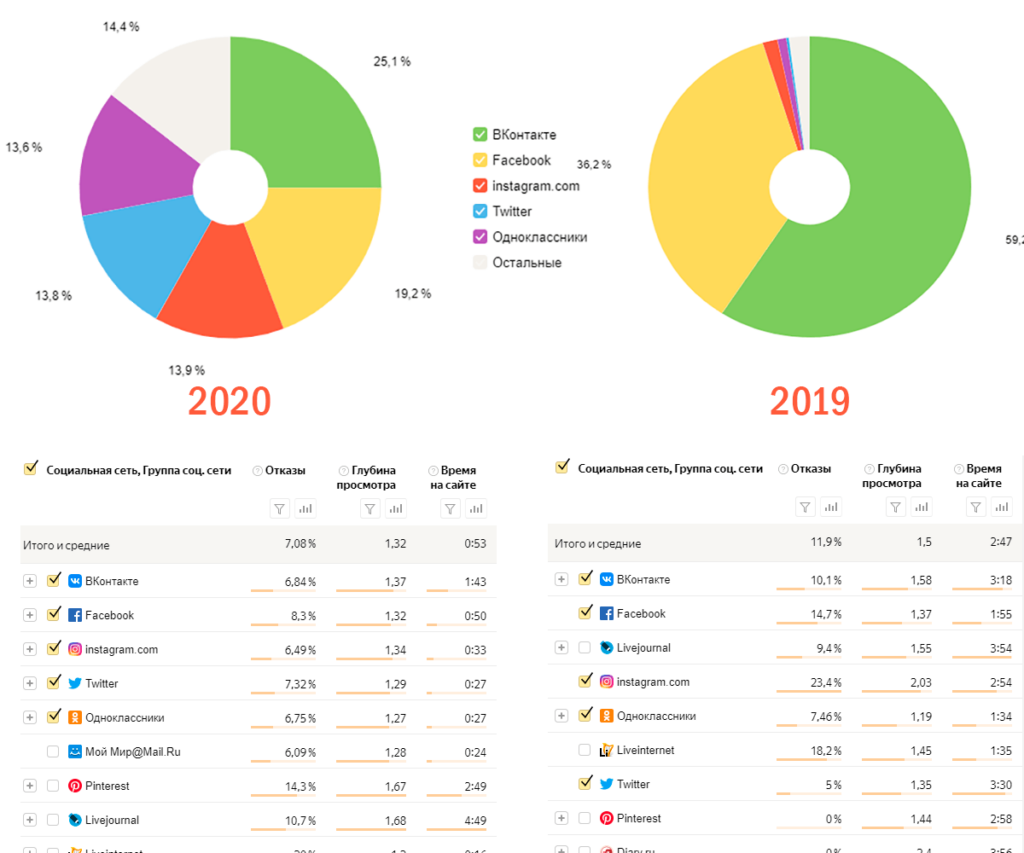

Переходы между социальными сетями, такими как VK, Facebook, Instagram, Twitter, Мой Мир@Mail.Ru, Одноклассники, за 2020 год распределились практически поровну, что противоестественно. Большинство визитов из социальных сетей длятся по 5-20 секунд и за это время посещается по 2 страницы. Раньше, когда ботов не было, визиты из социальных сетей имели совсем другой характер.

Я продвигаю сайт в VK и Facebook, поэтому в 2019 основной трафик из социальных сетей приходился на них. В 2020 я продолжила продвигать сайт именно в этих сетях, но результат совсем другой. Настоящие, заинтересованные в моем контенте пользователи социальных сетей просто утонули в толпе ботов. Их практически не видно на диаграмме за 2020 год.

Пока создатели ботов не научили своих подопечных читать и адекватно листать страницу. Бота легко можно узнать по поведению на сайте, посмотрев записи Вебвизора.

Многие боты, посещающие мой сайт, совершают хаотичные движения вверх и вниз в первых двух экранах смартфона. На таких скоростях скролла человеку трудно что-то прочитать. Очевидно, авторы бота не в состоянии предположить длину страницы конкретного сайта и на всякий случай не листают слишком далеко.

Все фотографии на сайте у меня вставлены через Lightbox. Бот иногда случайно нажимает на фото, оно всплывает, а эта глупая сущность продолжает скролить страницу под фотографией, будучи не в состоянии её закрыть.

Боты не всегда совершают короткие визиты, есть и такие, которые вполне реалистично способны пролистать страницу до конца. Они проявляют себя в равных интервалах между касаниями экрана и равномерной скоростью прокрутки. Человеку трудно воспроизвести такое идеальное поведение, учитывая что на странице местами вставлены фото, куски текста между фотографиями не равны друг другу. Человек обычно хотя бы какую-то часть страницы читает более внимательно, какие-то фото просматривает, какие-то пролистывает.

Иногда бот совершает переход по ссылке на моем сайте, которой не было на экране в момент перехода. Тоже явное палево.

Многие заходы совершаются с сети Московского метрополитена — Metropolitan branch of OJSC MegaFon ночью, т.е. когда метро не работает. Это что? Ремонтные работники интересуются, как им съездить в Лиссабон, а через 5 секунд вспоминают, что карантин на дворе и в спешке покидают страницу чтобы не травить душу? Вы можете в это поверить?

Вообще создается впечатление, что визиты ботов на сайт равномерно размазаны по времени суток.

Зачем нужны боты

Боты нужны для накрутки поведенческих факторов в Яндексе и Google. В Яндексе накрутки позволяют влететь в топ по нужным запросам буквально за 2-3 недели; в Гугл процесс идет дольше, стоит дороже, но тоже хорошо работает.

Яндекс сделал поведенческие факторы одним из ведущих факторов ранжирования в 2018 году и с тех пор понеслось. Накрутчики начали клепать ботов на потоке, сначала это были довольно примитивные программы. Поисковые системы запустили меры противодействия этим печальным явлениям, распознавали ботов по параметрам визитов, таким как User agent, Referer, cookie и т.д.

В результате производители ботов достигли совершенства в своем искусстве, теперь у ботов все параметры визитов идеально совпадают с таковыми у людей. У ботов есть аккаунты в социальных сетях, там даже что-то написано, размещены фотографии и поздравления с праздниками. Сейчас есть сервисы в интернете, которые могут создать вполне реальное фото человека, который никогда не сосуществовал. Распознать ботов на входе на сайт по параметрам визитов стало практически невозможно.

До марта 2020 я со своим информационным сайтом ничего не знала о ботах, потому что бота было относительно легко программировать, совсем не обязательно иметь правильные параметры, накрутка поведенческих и так работала. Поисковые системы закрутили гайки, и производителям ботов потребовалось перед накруткой коммерческого сайта нагуливать своих ботов на прочих сайтах, чтобы они обзавелись возрастом, историей в браузере, cookie и подобными вещами.

Нагуливать бота нужно по интересам, то есть свои интересы бот должен продемонстрировать поисковым системам. На моем сайте очевидно нагуливают автолюбителей. Идут прямые заходы на страницы, связанные с автопутешествиями.

Чем вредны боты

Боты сводят практически на нет всю статистику посещаемости сайта. Очень трудно становится оценить, сколько реальных людей посещало страницы. Получается, что трафик есть, а конверсия равна нулю. По моим партнерским ссылкам переходят, но никто ничего не покупает. Данные Яндекс.Метрики и Google аналитики превращаются в филькину грамоту.

Обычно, я действовала по алгоритму: эта страница пользуется успехом у людей, её часто посещают — надо её улучшить. Такая тактика всегда приносила успех. Теперь нужно сначала оценить источники трафика, убедиться, что статью посещают люди, а не боты. У меня появились лишние хлопоты.

Боты ухудшают поведенческие факторы на странице, большая часть из них делает очень короткие визиты с ерзаньем в самом начале. Я переписываю статьи, стараюсь структурировать информацию и вся работа насмарку. Время на сайте неуклонно уменьшается, отказы увеличиваются.

Существует риск бана за накрутку поведенческих факторов от поисковых систем, ведь доказать, что не я сама организовала этот трафик ботов на сайт невозможно. Сейчас у Яндекса нет санкций за накрутку поведенческих факторов, но кто знает, может быть через неделю или месяц санкции вступят в силу.

Могут забанить в Adsense или РСЯ, так как боты скликивают рекламу. Когда я существенно уменьшила поток ботов на сайт, мой доход с AdSense просел.

Я уже боюсь выставлять самые лучшие и актуальные статьи на главную страницу: о них узнают боты и начнут их накручивать.

Что можно сделать?

Что точно не помогает

Для начала замечу, что на моем сайте последние 4 года стоит плагин безопасности iThemes Security и я использую Cloudflare:

- По IP iThemes Security банит всех хакеров из базы сайта HackRepair.com.

- Я заблокировала по User Agent 206 самых разнообразных ботов, не имеющих отношения к накрутчикам, просто для уменьшения нагрузки на сервер.

- В Cloudflare у меня подключен Argo (от 5$ в месяц), и он по своим базам отсекает до 40% злоумышленников.

- Я перенастроила Cloudflare Firewall Setting: повысила Security Level c рекомендованного Medium до High, подключила Bot Fight Mode, JavaScript Detections, Browser Integrity Check, Privacy Pass Support.

Все вышеперечисленные методы не помогают в борьбе с российскими ботами, предназначенными для накрутки поведенческих факторов в Яндексе, вообще никак. Параметры визитов у русских ботов в полном порядке, всё очень натурально.

Очень рискованно банить ботов по диапазонам IP. Они используют реальные IP мобильных операторов Megafon, MTS, Tele2, BeeLine. Забанишь по IP практически сразу отсечешь солидную часть настоящих пользователей со смартфонов. Я пыталась выделить IP накрутчиков, за 24 часа у меня получилось 542 неповторяющихся IP. То есть их очень много.

Банить пользователей из социальных сетей

Я решила забанить пользователей из социальных сетей. Не всех, а только тех, в которых я не продвигаюсь. Переходы на мой сайт идут со следующего списка социальных сетей:

- VK

- Мой Мир@Mail.Ru

- Одноклассники

- Youtube

- Яндекс-Дзен

Инстаграм позволяет поставить всего одну ссылку в профиле. Я не верю, что кто-то абсолютно бескорыстно будет ссылаться на мой сайт из своего профиля. Свой инстаграм забросила как не оправдавший надежды. Времени на него тратиться много, а переходов на сайт практически нет. Поэтому инстаграм отправила в бан целиком.

Яндекс.Дзен также весьма ревностно относится к ссылкам — за них легко могут прикрыть аккаунт или лишить показов статью со ссылками. Перед тем, как забанить переходы с Дзена, я сделала поиск в нём по имени своего домена. Ни одной активной ссылки на мой сайт нет — только упоминания @trip-together.ru под фотографиями.

Мой Мир@Mail.Ru и Twitter совершенно не популярны, количество переходов с них на сайт совершенно ничтожно по сравнению с трафиком ботов. Однозначный бан.

На YouTube у меня есть заброшенный канал, я его использовала чтобы хранить видео, которое вставляю иногда в статьи. Видео у меня по 1-2 минуты. Ожидать сколь-нибудь значительного трафика оттуда не приходится. YouTube в бан целиком.

Ссылки — валюта интернета, большинство из них покупается за деньги или проставляется на основе договоренностей о взаимном PR. Никто не будет ставить ссылку бесплатно с трастового сайта или раскрученного аккаунта в социальной сети, популярного канала на YouTube. Не надо питать иллюзий.

Для Facebook и Vk, в которых я продвигаюсь забанила только переходы на определённые статьи. Боты атакуют не все страницы сайта: пострадали статьи, которые за последние полгода побывали на главной, и часть страниц на около автомобильную тематику. Из всего этого богатства я выбрала только 5 страниц, на которые идёт самый масштабный трафик из социальных сетей, и повесила на них Cloudflare Challenge Captcha.

Банить прямые заходы

Я проанализировала прямые заходы на определённые статьи и главную страницу, просмотрела записи визитов в Вебвизоре. Там видно, что все прямые заходы осуществляют боты — повесила на эти события Cloudflare JS Challenge.

Основная печаль заключается в том, что всегда остается риск забанить реальных пользователей. Нужно принимать решение на основании количественных оценок и вреда наносимого ботами.

Банить переходы с http

Я полазила по сервисам, предлагающим накрутку трафика на сайт, и совершенно случайно выяснила, что часть из них рекомендует своим пользователям делать поддельные переходы на чужие сайты с протокола http, с https переходы не получаются по техническим причинам, поэтому мне удалось отсечь почти все переходы с левых сайтов на мой, это сработало, осталось совсем чуть-чуть переходов с сайтов. Я думаю, это просто реферальный спам.

У меня есть несколько рабочих ссылок с сайтов с http. Я их просто добавила в исключения, так как в общей массе их совсем немного.

Как технически это реализовать

Я занималась подбором алгоритмов фильтрации входящего трафика в Cloudflare Firewall. Там это делать очень удобно. Пишешь логическое выражение и сразу идешь смотреть Firewall Events, если что-то не так, это становится заметно буквально в первую минуту. Так, один раз я заблокировала доступ на сайт всем ботам, включая Google и Яндекс, попутно узнала, что мой сайт по какой-то причине посещают боты Amazon.

Ниже привожу статистику из Farewall Cloudflare. К сожалению, боты постепенно перетекают на другие страницы. В самом начале работы по блокировке у меня самый большой бот трафик шёл с соцсетей, затем они переместились на прямые заходы.

Всё то же самое можно проделать и через файл .htaccess. Для проверки правильности настроек придётся лазить по логам сервера, что гораздо менее удобно. Их нужно скачивать и загружать в какую-нибудь вспомогательную программу, например, Microsoft Power BI, сегментировать.

Как я фиксировала результаты

На данный момент я поставила на сайт систему статистики Finteza методом проксирования. Это абсолютно бесплатно, скрипт весит 30 кБ, pagespeed на него совсем не ругается. Finteza пытается оценивать качество трафика на сайт по так называемым finger prints (тем факторам, которые мы можем наблюдать в вебвизоре). Свои секреты Finteza вполне справедливо не раскрывает и правильно делает.

Finteza более предназначена для коммерческих сайтов, дающих рекламу. Но для того, чтобы оценить количественные характеристики бот трафика вполне сойдет и для информационных проектов. Ниже приведены диаграммы в стиле до и после. Я блокировала прямые заходы, трафик из социальных сетей и реферальный (YouTube — это реферальный трафик).

Из недостатков Finteza: она работает только для десктопной версии сайта. На турбо страницы и amp-версии её поставить невозможно. В Finteza есть код для amp, но сразу после внедрения этого кода у меня появилась надпись в search console «Ошибка: Нельзя использовать собственный код JavaScript».

Отчёт «Роботы» в Яндекс.Метрике совершенно не учитывает вот этих ботов — он их считает настоящими пользователями. Никакого всплеска на нём в конце марта и конце сентября не было и нет.

Сторонние сервисы фильтрации ботов

Я знаю по крайней мере два платных сервиса, предлагающих фильтрацию ботов. Я устанавливала BotFAQtor.ru. Там есть бесплатный тестовый период. BotFAQtor предлагает защиту от скликивания рекламы, антибот для сайта, укорачиватель ссылок. Установка на сайт на WordPress происходит в один клик при помощи плагина, даже настраивать ничего не нужно.

Суть работы заключается в том, что все запросы перенаправляются на сервис BotFAQtor, там проверяются и только после проверки происходит загрузка страницы. Этот метод ожидаемо роняет скорость загрузки по Google pagespeed в 10-15%, при этом нельзя сказать, что боты совсем пропали. BotFAQtor блокировал на моём сайте 15-20 ботов в сутки. Я решила, что такое мизерное количество не стоит такого масштабного просаживания скорости загрузки.

В общем, любой сервис, осуществляющий фильтрацию на своей стороне будет существенно ухудшать скорость загрузки, тут вариантов нет. Применение BotFAQtor против скликивания рекламы, я думаю оправдано, это хоть как-то уменьшит денежные потери. При этом происходит замедление загрузки рекламных баннеров, а не сайта, что совсем другое дело.

Попробовать извлечь выгоду из того, что не в силах победить

Больше всего страдают от ботов коммерческие сайты, а не информационные. Информационные даже могут словить от бото-процесса определённые выгоды. Можно, например, просто вставить в начало статьи рекламный блок и надеяться, что часть ботов будет случайно нажимать на рекламу. В свете почти полной отмены всякого туризма из-за карантина вполне себе рабочая тактика.

Коммерческие сайты платят за рекламу реальные деньги, а получают ботов вместо людей. Боты скролят странички, имитируют действия пользователей, но они никогда ничего не покупают, а за клики бизнес заплатил свои кровные. Во время коронакризиса это очень болезненно.

Скликивание рекламы ботами стало настоящей проблемой всех, кто эту рекламу покупает. Иногда рекламные сети возвращают деньги, а иногда нет. Попробуйте докажите Яндексу или Google, что в сети бродят боты и скликивают рекламу.

Неучтенные риски

Я не учитывала то, что поисковый трафик тоже может быть трафиком ботов. Априори, я предполагала, что накручивать инфо запросы совершенно не рентабельно, особенно на туристическом информационном сайте в эпоху карантина. Инфосайты просто случайно попадают в цепочку нагула ботов. Но я могу ошибаться и всё может измениться через какое-то время.

Основная накрутка осуществляется именно в поисковой выдаче. Главная цель любого бота — набрать в поисковой строке продвигаемый запрос и совершить переход на продвигаемый сайт. Нагул ботов по инфо сайтам и социальным сетям это всего лишь прелюдия этого замечательного процесса.

Остается уповать на всемогущий Яндекс и Google. Может быть они наконец решат проблему с накруткой поведенческих факторов. Таким гигантам сделать это намного проще, ведь у них работают ведущие программисты мира. Я потратила на изучение входящего трафика и попытки его отфильтровать целую неделю и отфильтровала только часть, выловить всё невозможно, закрываешь от ботов одни страницы, они переходят просто на другие.

Русскоязычные сайты, конечно, больше интересует Яндекс, у него по сравнению с Гуглом всё намного хуже с антифрод технологиями. 24 сентября 2020 года Яндекс выпустил очередной фильтр за накрутку поведенческих факторов, пытаются просто нивелировать эффект накрутки без бана, потому что определить кто крутил сайт — хозяин или конкурент — практически невозможно.

Но в конце сентября я как раз и почувствовала очередной всплеск трафика ботов. Производители ботов решили после изменения алгоритмов Яндекса просто еще усерднее нагуливать своих подопечных на ни в чем не повинных, белых и пушистых сайтах.

Другие мои статьи про технические аспекты ведения блога на WordPress вы можете почитать на моём сайте.

Давайте в комментариях обсудим ботов. Вы замечали на своём сайте солидный трафик из ботов? Что предпринимали? Поделитесь своими методами противодействия подобным явлениям. Может не стоит ничего делать, ведь всё происходящее не накрутка в отказы?